B站开源的语音生成模型,是首个支持精确时长控制的自回归零样本文本转语音模型,支持影视级配音生成!

现有自回归大规模文本转语音(TTS)模型在语音自然度方面具有优势,但其逐token生成机制难以精确控制合成语音的时长。这在需要严格视音频同步的应用(如视频配音)中成为显著限制。

本文提出了IndexTTS2,创新性地提出了一种通用且适用于自回归模型的语音时长控制方法。

该方法支持两种生成模式:一种可显式指定生成token数量以精确控制语音时长;另一种则自由自回归生成语音,同时忠实还原输入提示的韵律特征。

此外,IndexTTS2实现了情感表达与说话人身份的解耦,可独立控制音色和情感。在零样本设置下,模型能准确复刻目标音色(来自音色提示),同时完美还原指定的情感语调(来自风格提示)。

为提升高情感表达下的语音清晰度,我们引入GPT潜在表示,并设计了三阶段训练范式,提升生成语音的稳定性。为降低情感控制门槛,我们基于文本描述微调Qwen3,设计了软指令机制,有效引导语音生成所需情感。

多数据集实验结果表明,IndexTTS2在词错误率、说话人相似度和情感保真度方面均超越现有零样本TTS模型。

📣 更新日志

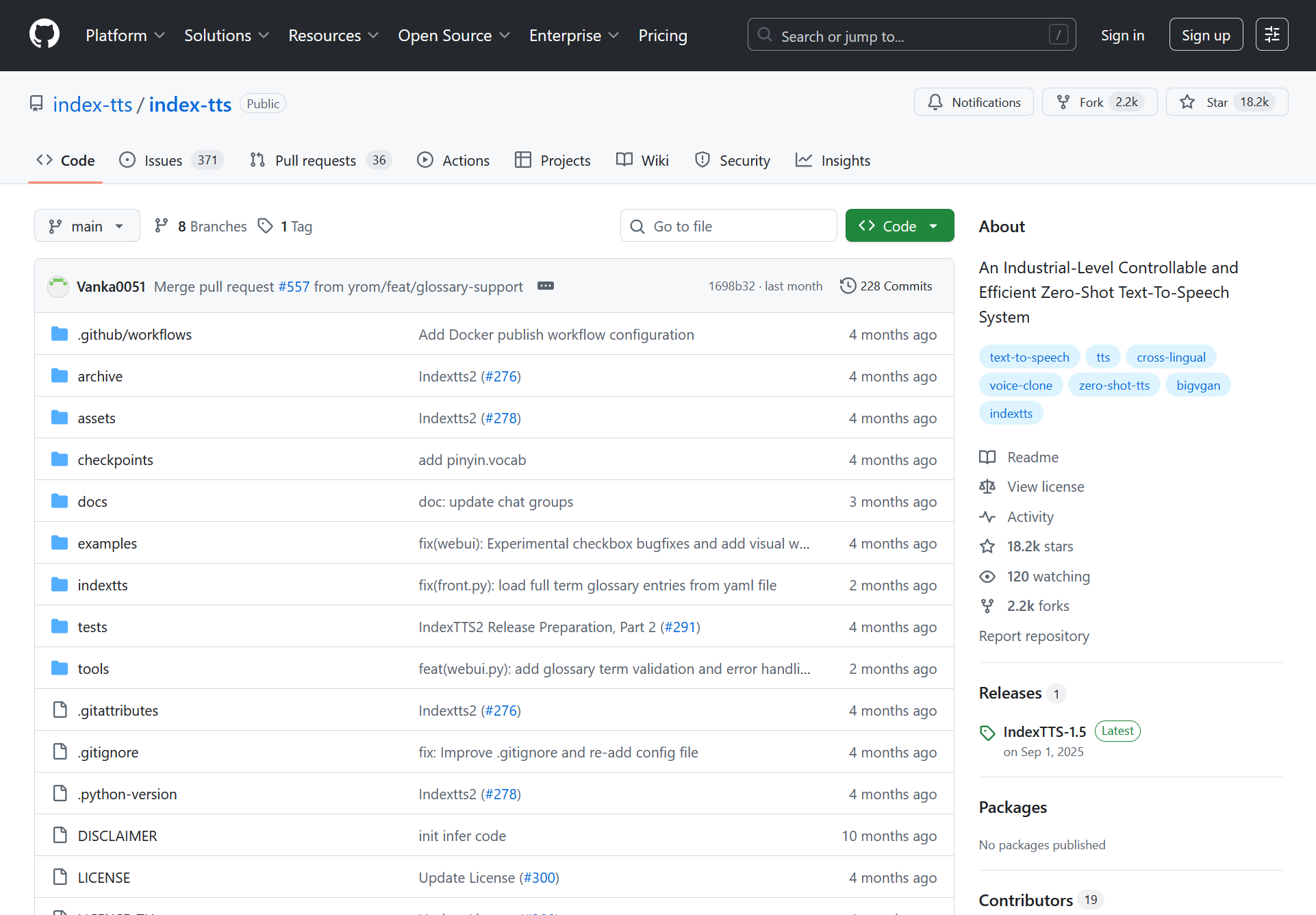

2025/09/08🔥🔥🔥 IndexTTS-2全球发布!- 首个支持精确合成时长控制的自回归TTS模型,支持可控与非可控模式。本版本暂未开放该功能。

- 模型实现高度情感表达的语音合成,支持多模态情感控制。

2025/05/14🔥🔥 IndexTTS-1.5发布,显著提升模型稳定性及英文表现。2025/03/25🔥 IndexTTS-1.0发布,开放模型权重与推理代码。2025/02/12🔥 论文提交arXiv,发布演示与测试集。

主要创新点:

- 提出自回归TTS模型的时长自适应方案。IndexTTS2是首个将精确时长控制与自然时长生成结合的自回归零样本TTS模型,方法可扩展至任意自回归大模型。

- 情感与说话人特征从提示中解耦,设计特征融合策略,在高情感表达下保持语义流畅与发音清晰,并开发了基于自然语言描述的情感控制工具。

- 针对高表达性语音数据缺乏,提出高效训练策略,显著提升零样本TTS情感表达至SOTA水平。

- 代码与预训练权重将公开,促进后续研究与应用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...